do IT differently ( 0.8.0 ) |

« Innovation is this amazing intersection between someone’s imagination and the reality in which they live » (Ron Johnson) |

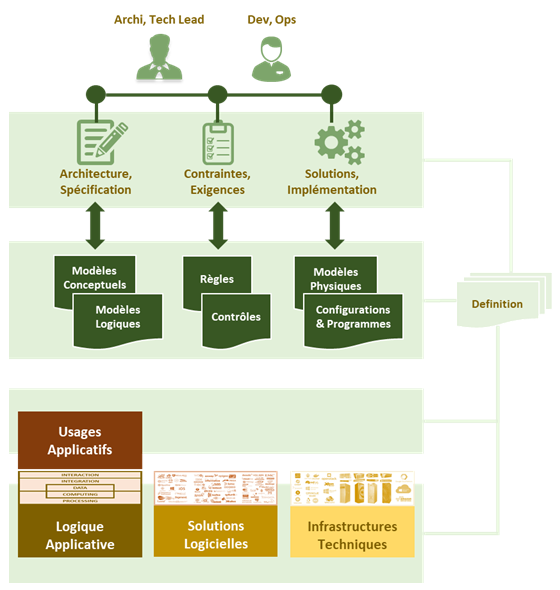

Introduction ▶ All as Definition

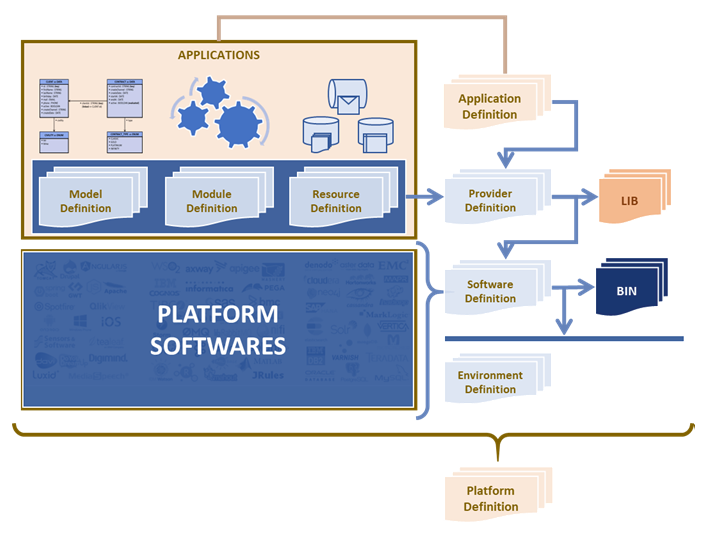

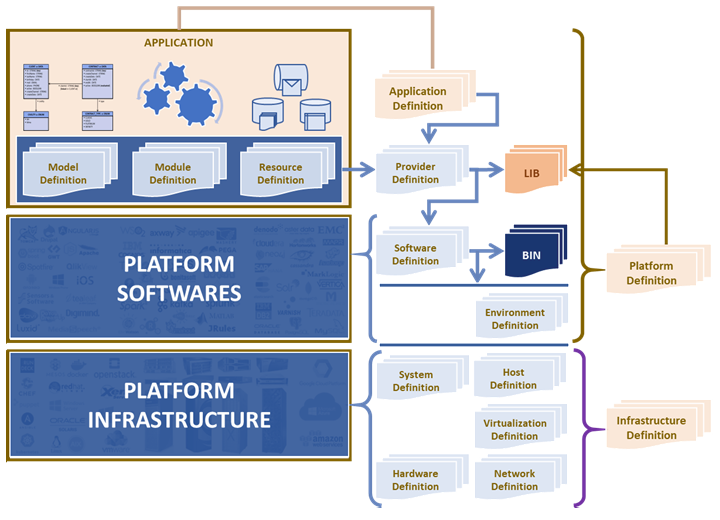

Du « Low Code » pour la définition d’Application

et par composition pour « Platform as Code » et « Infrastructure as Code »

afin que tout soit à la portée de tous les acteurs de l’IT

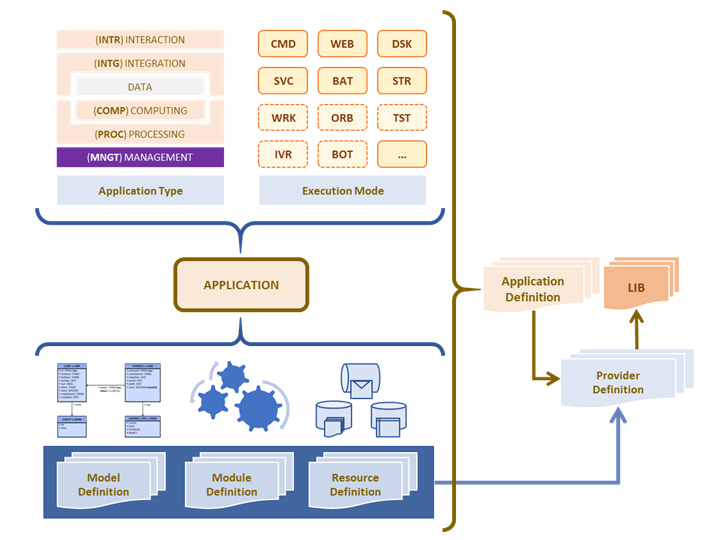

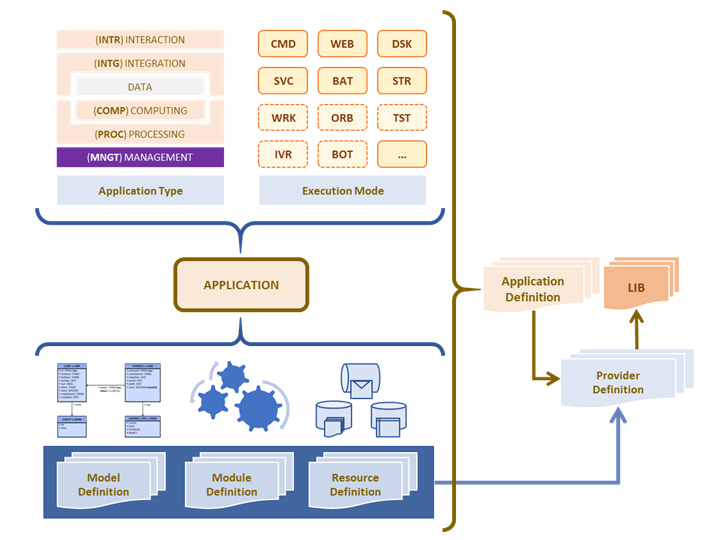

Description d'application

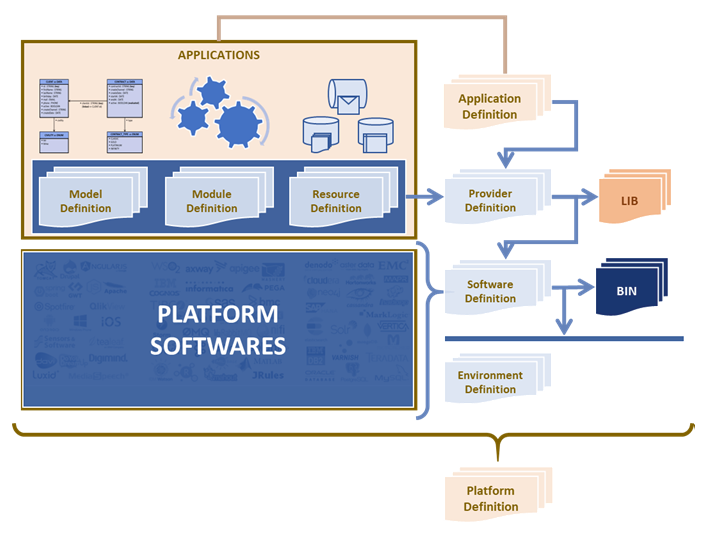

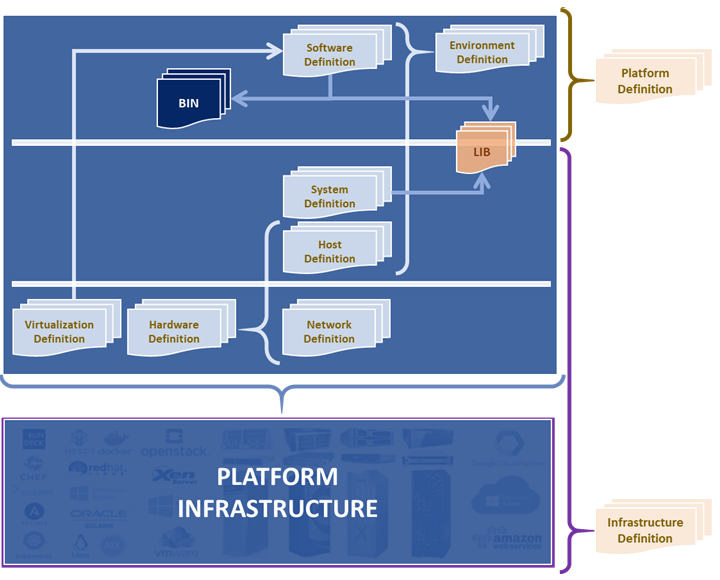

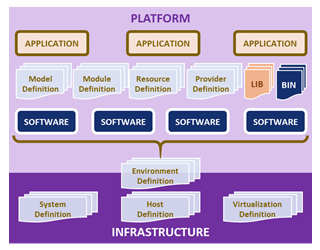

Description de platforme

La plateforme peut fournir les ressources aux applications qu'elle heberge :

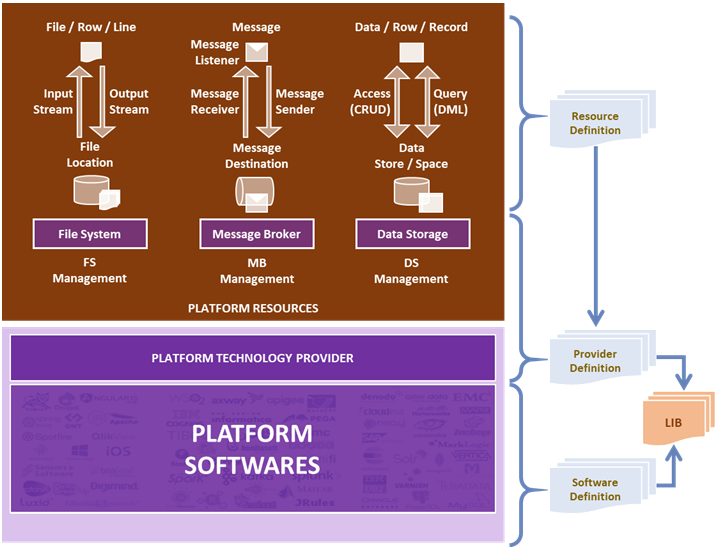

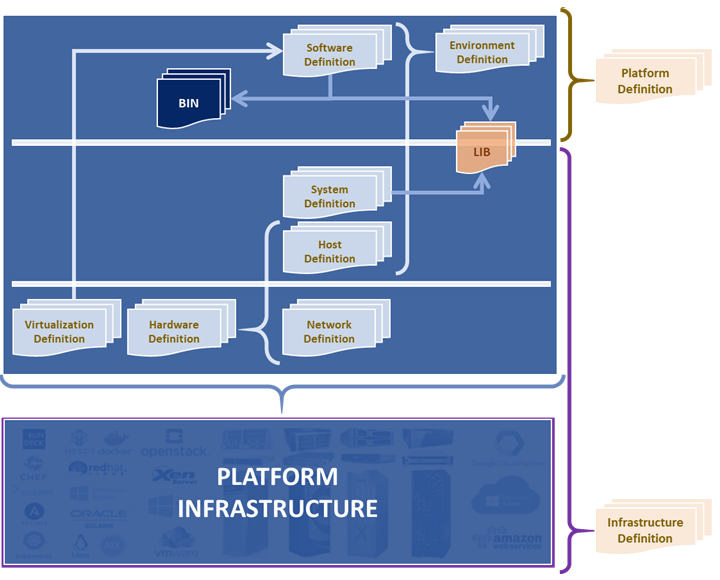

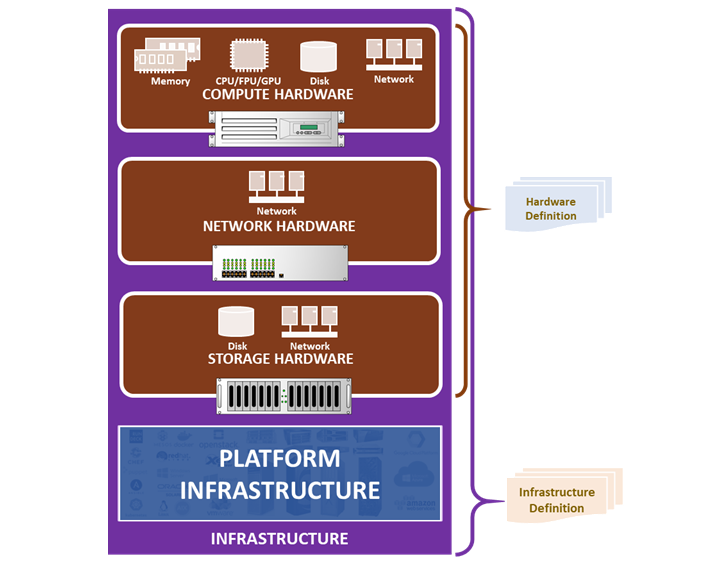

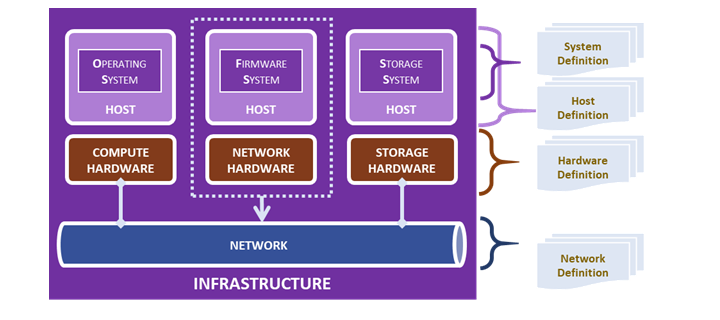

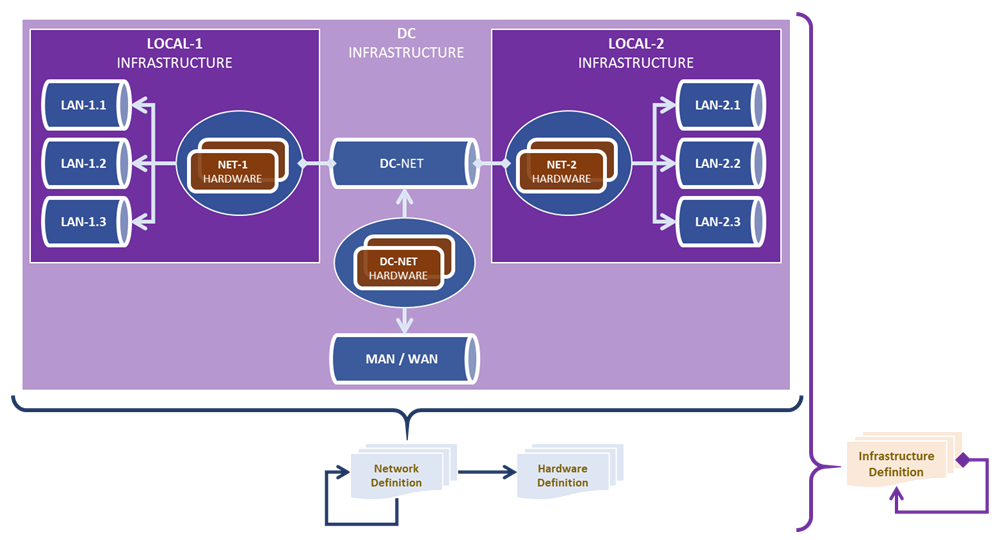

Description de l'infrastructure

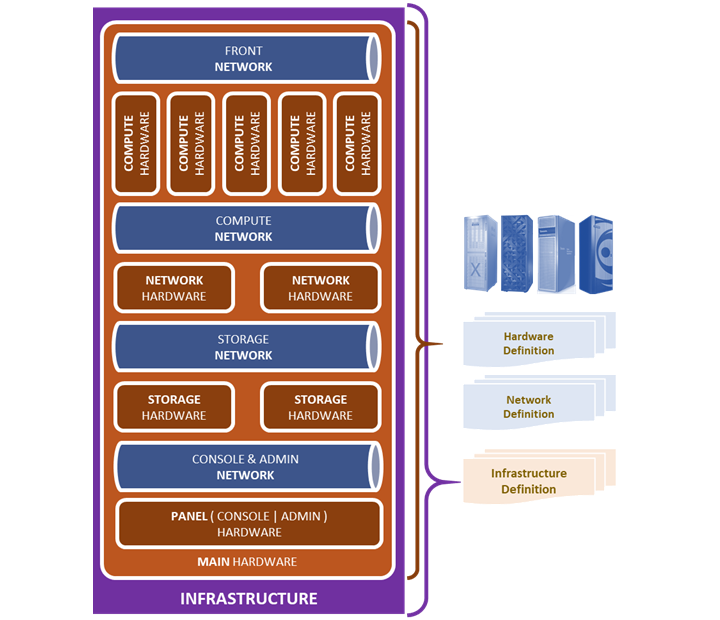

L'infrastructure est définie principalement par les éléments suivants :

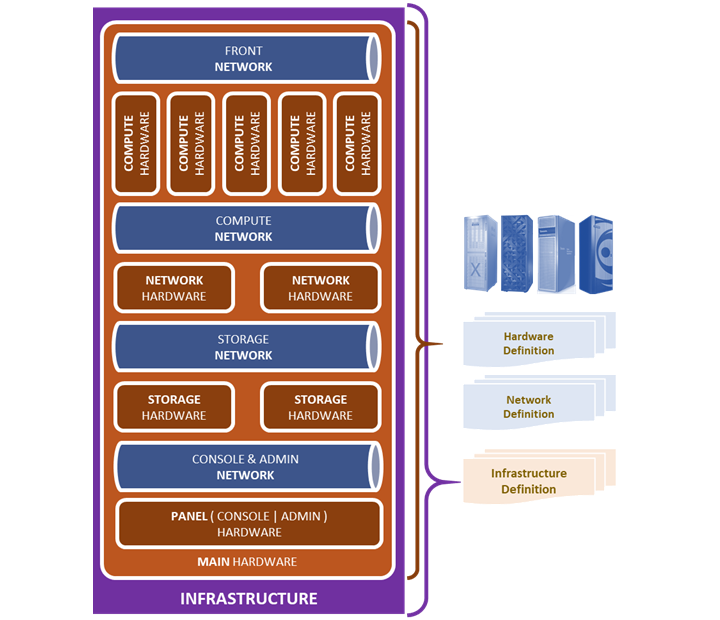

Parfois on peut avoir un matériel tout en un, dit « MAIN HARDWARE ». Ce type de matériel peut porter en lui tout seul un besoin d'infrastructure.

|

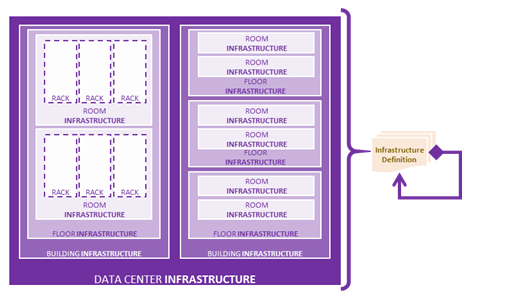

Comme nous venons de voir avec le matériel tout en un, l'infrastructure peut être portée par un seul gros matériel.

Et on peut envisager que l'infrastructure peut être représentées de manière modulaire et hiérarchique : |

|

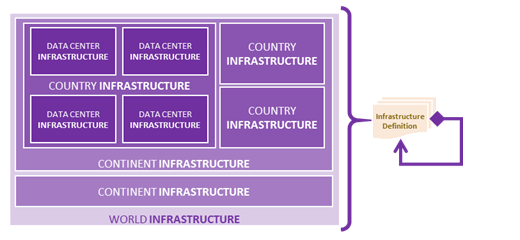

Cette hiérarchie de l’infrastructure peut aller plus loin avec plusieurs « DATA CENTER » repartis

|

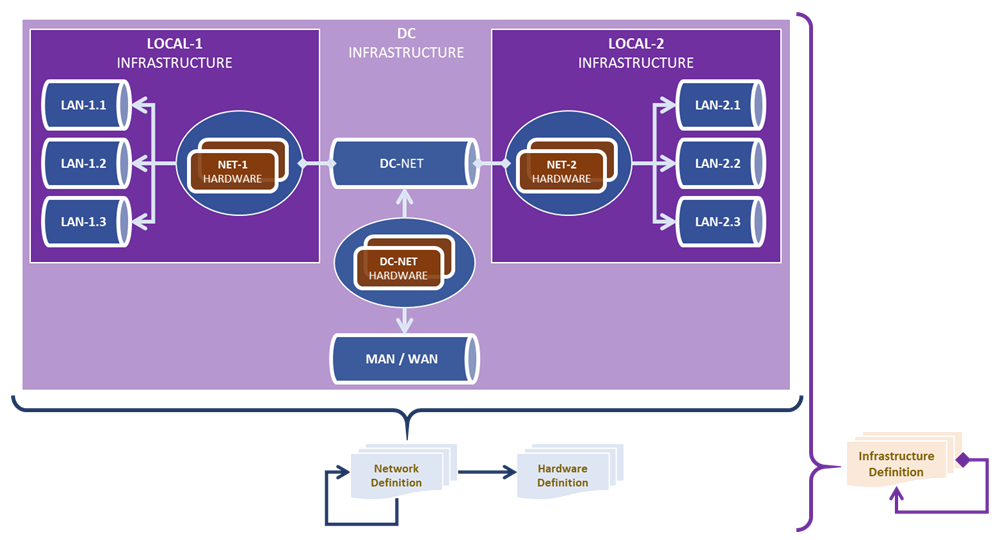

Cette hiérarchie qui s’applique au niveau de l’infrastructure affecte aussi le maillage du réseau.

« The Network is the Computer »

"do:IT" est compatible avec les composants à faible consommation de ressources, tels que Raspberry Pi.

« The Network is the Computer »

"do:IT" est compatible avec les composants à faible consommation de ressources, tels que Raspberry Pi.

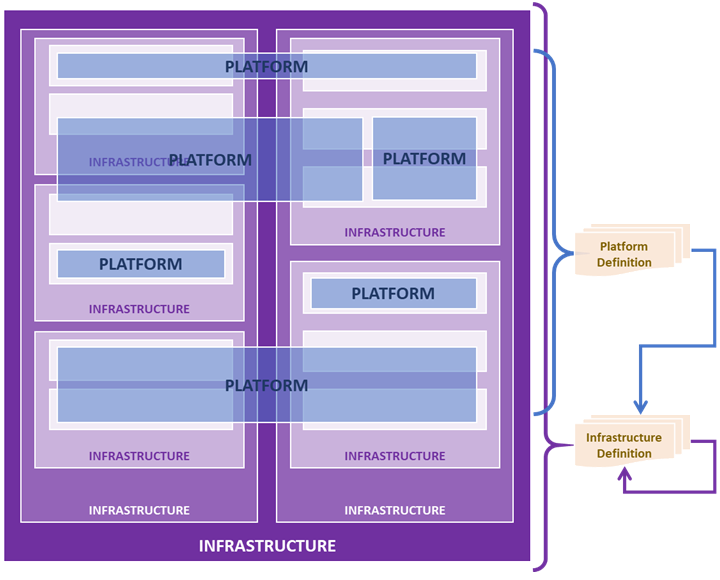

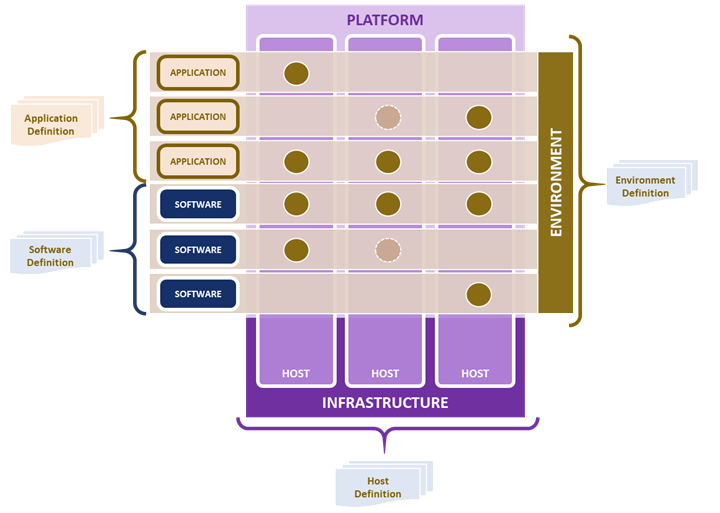

Projection de la plateforme sur l'infrastructure

|

Avec la hiérarchie de l’infrastructure, les plateformes applicatives doivent se retrouver au dessus.

Il est tout à fait envisageable à ce qu'une plateforme applicative soit repartie sur plusieurs infrastructures. |

|

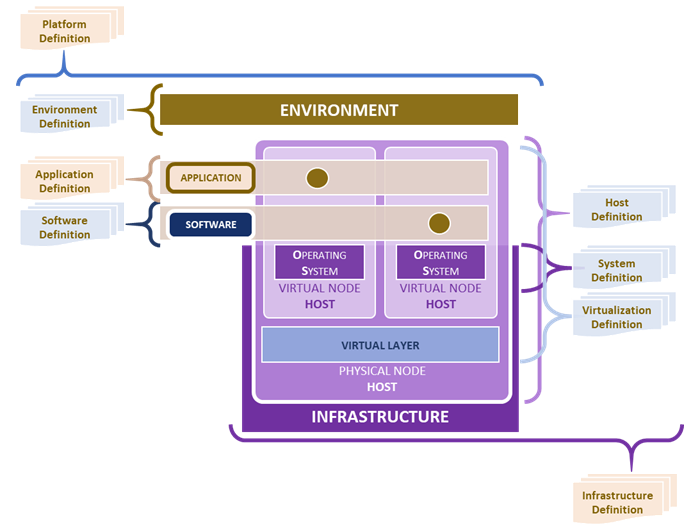

Comme indiqué par ce schéma, la liaison entre la plateforme applicative et l'infrastructure d'hébergement

est assurée par la définition « cf. Environment Definition »

car celle-ci décrit la topologie de déploiement des composants applicatifs et logiciels de la « PLATFORM » vers « l’INFRASTRUCTURE ».

|

|

C'est avec la définition « Environnement Definition » que l'on peut indiquer

Il est possible de préciser les besoins en ressources des composants suivant l’environnement cible. En tant qu'aspect, la sécurité peut être définie globalement au niveau de la plateforme mais peut être spécifique par type d'environnement |

|

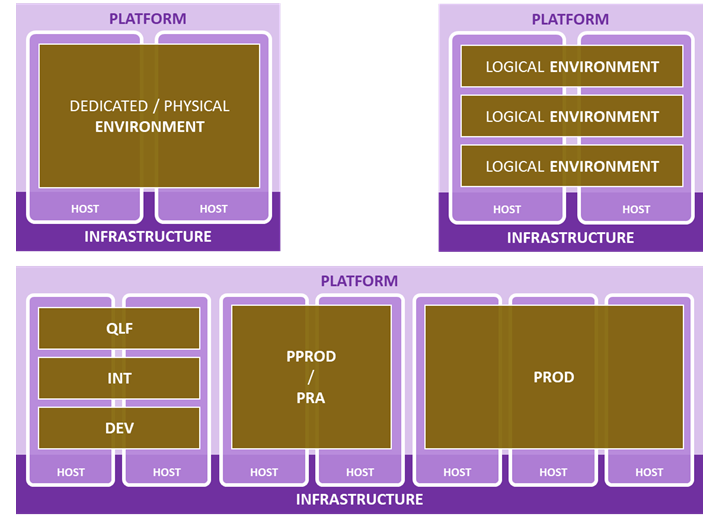

On peut considérer 2 modes de projection de l’environnement :

|

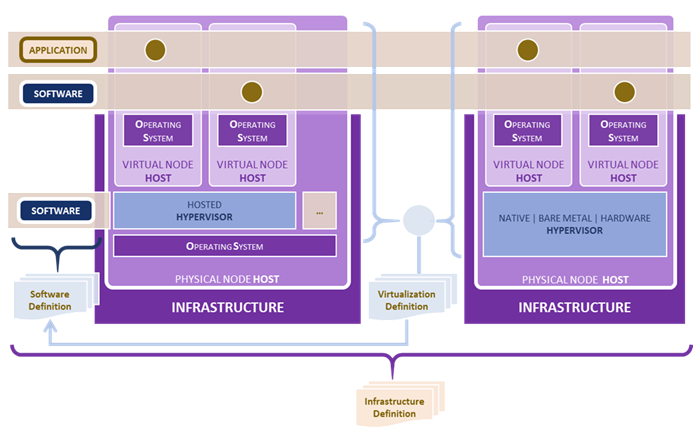

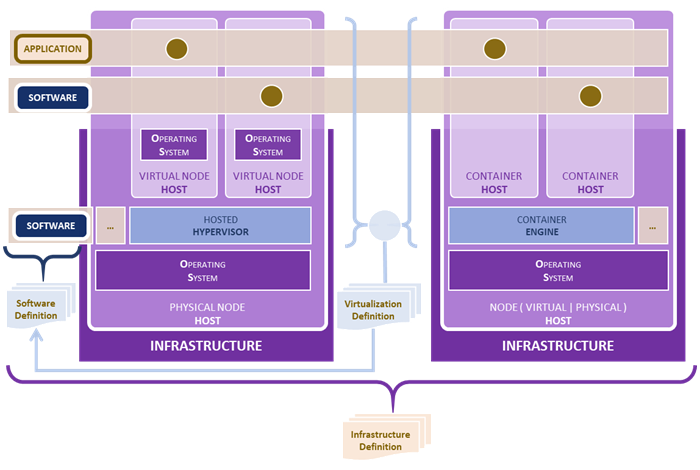

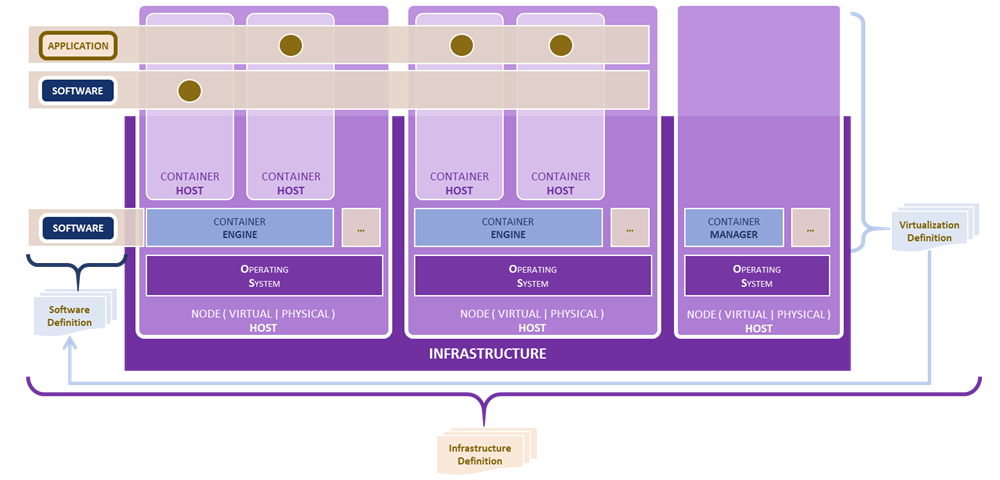

Virtualisation de l'infrastructure

Isolation de l'espace d'exécution

|

Ainsi la virtualisation des ressources est nécessaire : « VIRTUAL LAYER ». |

|

et qui peut être faite au niveau matériel « NATIVE ou BARE METAL ou HARDWARE » ou au niveau de l’OS du matériel « HOSTED ». |

Isolation de l'espace d'exécution

|

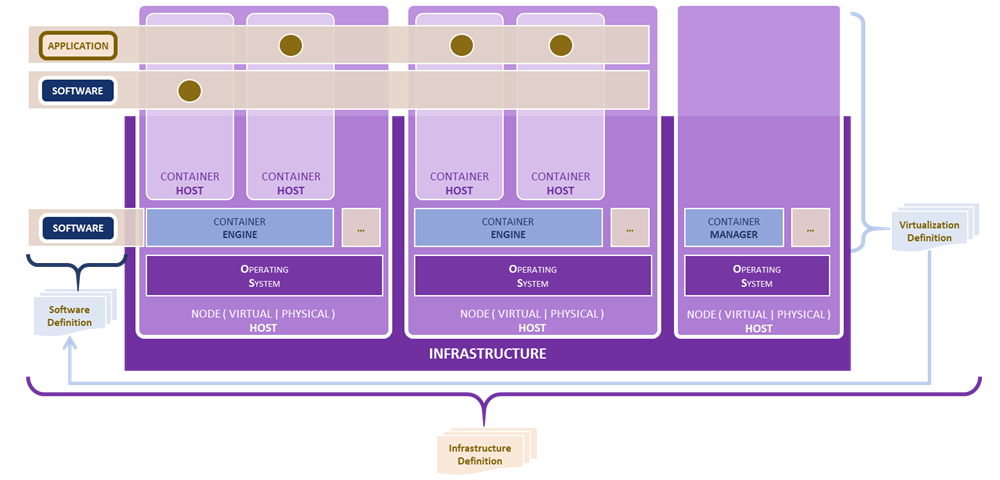

Le noyau de certains systèmes d’exploitation dispose de mécanisme de cloisonnement ou d’isolement de l’espace d’exécution d’un composant applicatif ou logiciel,

dit « CONTAINER ENGINE »,

ex : Les « CONTAINER » permettent de rationaliser davantage les ressources mais suivant la maturité des solutions et des systèmes, les fuites de ressources peuvent apparaître. |

Pour l'expansion des instances, les « CONTAINER MANAGER » offre les capacités de « scalabilité horizontale » des « CONTAINER ENGINE »,

ex :✓

« Kubernetes »,

✓

« Nomad de HashiCorp »,

✓

« Nutanix ».

ex :

L’usage des systèmes distribués nous amène à une autre technique de cloisonnement et de gestion des ressources,

les « RESOURCE MANAGER »,

ex :✓

« YARN » avec ou sans Hadoop,

✓

« Mesos ».

Les « RESOURCE MANAGER » peuvent être limités sur leur capacité de gestion des ressources, ex :✓

« YARN » est seulement pour les applications Java.

ex :

Les « RESOURCE MANAGER » peuvent être limités sur leur capacité de gestion des ressources, ex :